반응형

Convex, non-Convex

Cost Function의 그래프가 Local minimun이 있는지 없는지 여부

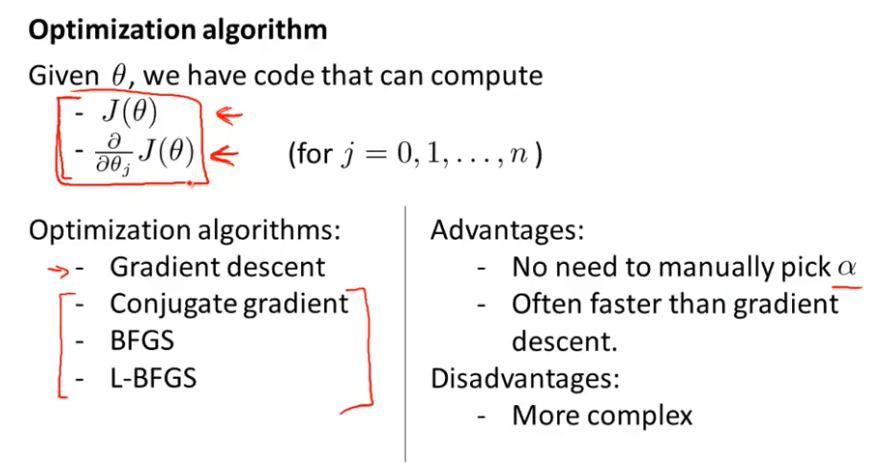

Optimization Algorithm

Gradient Descent만 있는줄알았는데, 다른 최적화 알고리즘이 있다고하여, 기록차 적음

장점

- 우리가 흔히알고있는 Learning Rate를 따로 지정해줄필요없음

- 때때론 Gradient Descent보다 빠른성능을 자랑

단점

- 계산량이 많음(GD보다)

Pytorch 라이브러리(pytorch.org/docs/stable/optim.html)

torch.optim.LBFGS(params,

lr=1,

max_iter=20,

max_eval=None,

tolerance_grad=1e-07,

tolerance_change=1e-09,

history_size=100,

line_search_fn=None)반응형

'Data > Data Science' 카테고리의 다른 글

| [Pytorch] torch.nn layer 함수 정리 (추가정리중) (0) | 2021.05.03 |

|---|---|

| [ML] Clustering 정리 및 DBSCAN (0) | 2021.04.22 |

| [머신러닝] LGBM, XGBoost, GBM (2) | 2021.02.03 |

| [Gradient Descent] 경사하강법 (0) | 2021.01.13 |

| [Pytorch] Autoencoder Base code (0) | 2020.11.29 |